mirror of

https://github.com/phil-opp/blog_os.git

synced 2025-12-16 14:27:49 +00:00

Compare commits

16 Commits

2f1918bf71

...

ac94309114

| Author | SHA1 | Date | |

|---|---|---|---|

|

|

ac94309114 | ||

|

|

3183dc92e9 | ||

|

|

19150682df | ||

|

|

912566167c | ||

|

|

82f205956a | ||

|

|

d456410da2 | ||

|

|

48c3532c40 | ||

|

|

0c79f42e39 | ||

|

|

399eee2e19 | ||

|

|

2a338cf045 | ||

|

|

31eb517b4d | ||

|

|

2844d0fc8c | ||

|

|

b63ce2dc3c | ||

|

|

184db36e7c | ||

|

|

a108367d71 | ||

|

|

c1639cb9c2 |

1

blog/.gitignore

vendored

1

blog/.gitignore

vendored

@@ -1 +1,2 @@

|

||||

/public

|

||||

zola

|

||||

|

||||

@@ -1,5 +1,5 @@

|

||||

+++

|

||||

title = "A Freestanding Rust Binary"

|

||||

title = "Un binaire Rust autonome"

|

||||

weight = 1

|

||||

path = "fr/freestanding-rust-binary"

|

||||

date = 2018-02-10

|

||||

|

||||

@@ -12,8 +12,7 @@ translation_based_on_commit = "c1af4e31b14e562826029999b9ab1dce86396b93"

|

||||

translators = ["JOE1994", "Quqqu"]

|

||||

+++

|

||||

|

||||

운영체제 커널을 만드는 첫 단계는 표준 라이브러리(standard library)를 링크하지 않는 Rust 실행파일을 만드는 것입니다.

|

||||

이러한 실행파일은 운영체제가 없는 [bare metal] 시스템에서 동작할 수 있습니다.

|

||||

운영체제 커널을 만드는 첫 단계는 표준 라이브러리(standard library)를 링크하지 않는 Rust 실행파일을 만드는 것입니다. 이 실행파일은 운영체제가 없는 [bare metal] 시스템에서 동작할 수 있습니다.

|

||||

|

||||

[bare metal]: https://en.wikipedia.org/wiki/Bare_machine

|

||||

|

||||

|

||||

@@ -6,9 +6,11 @@ date = 2018-02-10

|

||||

|

||||

[extra]

|

||||

# Please update this when updating the translation

|

||||

translation_based_on_commit = "bd6fbcb1c36705b2c474d7fcee387bfea1210851"

|

||||

translation_based_on_commit = "096c044b4f3697e91d8e30a2e817e567d0ef21a2"

|

||||

# GitHub usernames of the people that translated this post

|

||||

translators = ["luojia65", "Rustin-Liu", "TheBegining"]

|

||||

translators = ["luojia65", "Rustin-Liu", "TheBegining", "liuyuran"]

|

||||

# GitHub usernames of the people that contributed to this translation

|

||||

translation_contributors = ["JiangengDong"]

|

||||

+++

|

||||

|

||||

创建一个不链接标准库的 Rust 可执行文件,将是我们迈出的第一步。无需底层操作系统的支撑,这样才能在**裸机**([bare metal])上运行 Rust 代码。

|

||||

@@ -43,10 +45,10 @@ translators = ["luojia65", "Rustin-Liu", "TheBegining"]

|

||||

我们可以从创建一个新的 cargo 项目开始。最简单的办法是使用下面的命令:

|

||||

|

||||

```bash

|

||||

> cargo new blog_os

|

||||

cargo new blog_os --bin --edition 2018

|

||||

```

|

||||

|

||||

在这里我把项目命名为 `blog_os`,当然读者也可以选择自己的项目名称。这里,cargo 默认为我们添加了`--bin` 选项,说明我们将要创建一个可执行文件(而不是一个库);cargo还为我们添加了`--edition 2018` 标签,指明项目的包要使用 Rust 的 **2018 版次**([2018 edition])。当我们执行这行指令的时候,cargo 为我们创建的目录结构如下:

|

||||

在这里我把项目命名为 `blog_os`,当然读者也可以选择自己的项目名称。默认情况下,即使不显式指定,cargo 也会为我们添加`--bin` 选项,说明我们将要创建一个可执行文件(而不是一个库); 另外 `--edition 2018` 参数指明了项目的包要使用 Rust 的 **2018 版次**([2018 edition]),但在默认情况下,该参数会指向本地安装的最新版本。当我们成功执行这行指令后,cargo 为我们创建的目录结构如下:

|

||||

|

||||

[2018 edition]: https://doc.rust-lang.org/nightly/edition-guide/rust-2018/index.html

|

||||

|

||||

@@ -158,7 +160,7 @@ error: requires `start` lang_item

|

||||

|

||||

我们通常会认为,当运行一个程序时,首先被调用的是 `main` 函数。但是,大多数语言都拥有一个**运行时系统**([runtime system](https://en.wikipedia.org/wiki/Runtime_system)),它通常为**垃圾回收**(garbage collection)或**绿色线程**(software threads,或 green threads)服务,如 Java 的 GC 或 Go 语言的协程(goroutine);这个运行时系统需要在 main 函数前启动,因为它需要让程序初始化。

|

||||

|

||||

在一个典型的使用标准库的 Rust 程序中,程序运行是从一个名为 `crt0` 的运行时库开始的。`crt0` 意为 C runtime zero,它能建立一个适合运行 C 语言程序的环境,这包含了栈的创建和可执行程序参数的传入。在这之后,这个运行时库会调用 [Rust 的运行时入口点](https://github.com/rust-lang/rust/blob/bb4d1491466d8239a7a5fd68bd605e3276e97afb/src/libstd/rt.rs#L32-L73),这个入口点被称作 **start语言项**("start" language item)。Rust 只拥有一个极小的运行时,它被设计为拥有较少的功能,如爆栈检测和打印**堆栈轨迹**(stack trace)。这之后,这个运行时将会调用 main 函数。

|

||||

在一个典型的使用标准库的 Rust 程序中,程序运行是从一个名为 `crt0` 的运行时库开始的。`crt0` 意为 C runtime zero,它能建立一个适合运行 C 语言程序的环境,这包含了栈的创建和可执行程序参数的传入。在这之后,这个运行时库会调用 [Rust 的运行时入口点](https://github.com/rust-lang/rust/blob/bb4d1491466d8239a7a5fd68bd605e3276e97afb/src/libstd/rt.rs#L32-L73),这个入口点被称作 **start语言项**("start" language item)。Rust 只拥有一个极小的运行时,它被设计为拥有较少的功能,如爆栈检测和打印**栈轨迹**(stack trace)。这之后,这个运行时将会调用 main 函数。

|

||||

|

||||

我们的独立式可执行程序并不能访问 Rust 运行时或 `crt0` 库,所以我们需要定义自己的入口点。只实现一个 `start` 语言项并不能帮助我们,因为这之后程序依然要求 `crt0` 库。所以,我们要做的是,直接重写整个 `crt0` 库和它定义的入口点。

|

||||

|

||||

@@ -241,6 +243,172 @@ cargo build --target thumbv7em-none-eabihf

|

||||

### 链接器参数

|

||||

|

||||

我们也可以选择不编译到裸机系统,因为传递特定的参数也能解决链接器错误问题。虽然我们不会在后面使用到这个方法,为了教程的完整性,我们也撰写了专门的短文章,来提供这个途径的解决方案。

|

||||

如有需要,请点击下方的 _"链接器参数"_ 按钮来展开可选内容。

|

||||

|

||||

<details>

|

||||

|

||||

<summary>链接器参数</summary>

|

||||

|

||||

在本章节中,我们讨论了Linux、Windows和macOS中遇到的链接错误,并阐述如何通过传递额外参数来解决这些错误。注意,由于不同操作系统的可执行文件内在格式不同,所以对于不同操作系统而言,所适用的额外参数也有所不同。

|

||||

|

||||

#### Linux

|

||||

|

||||

在Linux下,会触发以下链接错误(简化版):

|

||||

|

||||

```

|

||||

error: linking with `cc` failed: exit code: 1

|

||||

|

|

||||

= note: "cc" […]

|

||||

= note: /usr/lib/gcc/../x86_64-linux-gnu/Scrt1.o: In function `_start':

|

||||

(.text+0x12): undefined reference to `__libc_csu_fini'

|

||||

/usr/lib/gcc/../x86_64-linux-gnu/Scrt1.o: In function `_start':

|

||||

(.text+0x19): undefined reference to `__libc_csu_init'

|

||||

/usr/lib/gcc/../x86_64-linux-gnu/Scrt1.o: In function `_start':

|

||||

(.text+0x25): undefined reference to `__libc_start_main'

|

||||

collect2: error: ld returned 1 exit status

|

||||

```

|

||||

|

||||

这里的问题在于,链接器默认包含了C启动例程,即构建名为 `_start` 的入口函数的地方。但其依赖一些C标准库 `libc` 中的符号,而我们已经使用 `no_std` 开关排除掉了这些符号,所以链接器报告了这些错误。要解决这个问题,我们需要通过 `-nostartfiles` 参数来告诉链接器不要使用C启动例程功能。

|

||||

|

||||

通过 `cargo rustc` 可以传递链接器参数,该命令和 `cargo build` 的效果完全一致,但是可以将参数传递给rust的底层编译器 `rustc`。`rustc` 支持 `-C link-arg` 参数,此参数可以传递参数给配套的链接器。那么以此推断,我们的编译语句可以这样写:

|

||||

|

||||

```

|

||||

cargo rustc -- -C link-arg=-nostartfiles

|

||||

```

|

||||

|

||||

现在我们编译出的程序就可以在Linux上独立运行了。

|

||||

|

||||

我们并不需要显式指定入口函数名,链接器默认会查找 `_start` 函数作为入口点。

|

||||

|

||||

#### Windows

|

||||

|

||||

|

||||

在Windows下,会触发以下链接错误(简化版):

|

||||

|

||||

```

|

||||

error: linking with `link.exe` failed: exit code: 1561

|

||||

|

|

||||

= note: "C:\\Program Files (x86)\\…\\link.exe" […]

|

||||

= note: LINK : fatal error LNK1561: entry point must be defined

|

||||

```

|

||||

|

||||

错误信息 “entry point must be defined” 意味着链接器没有找到程序入口点。在Windows环境下,默认入口点[取决于使用的子系统][windows-subsystems]。对于 `CONSOLE` 子系统,链接器会寻找 `mainCRTStartup` 函数作为入口,而对于 `WINDOWS` 子系统,入口函数名叫做 `WinMainCRTStartup`。要复写掉入口函数名的默认设定,使其使用我们已经定义的 `_start` 函数,可以将 `/ENTRY` 参数传递给链接器:

|

||||

|

||||

[windows-subsystems]: https://docs.microsoft.com/en-us/cpp/build/reference/entry-entry-point-symbol

|

||||

|

||||

```

|

||||

cargo rustc -- -C link-arg=/ENTRY:_start

|

||||

```

|

||||

|

||||

显而易见,从链接参数上看,Windows平台使用的链接器和Linux平台是完全不同的。

|

||||

|

||||

此时可能你还会遇到这个链接错误:

|

||||

|

||||

```

|

||||

error: linking with `link.exe` failed: exit code: 1221

|

||||

|

|

||||

= note: "C:\\Program Files (x86)\\…\\link.exe" […]

|

||||

= note: LINK : fatal error LNK1221: a subsystem can't be inferred and must be

|

||||

defined

|

||||

```

|

||||

|

||||

该错误的原因是Windows平台下的可执行文件可以使用不同的[子系统][windows-subsystems]。一般而言,操作系统会如此判断:如果入口函数名叫 `main` ,则会使用 `CONSOLE` 子系统;若名叫 `WinMain` ,则会使用 `WINDOWS` 子系统。然而此时我们使用的入口函数名叫 `_start` ,两者都不是,此时就需要显式指定子系统:

|

||||

|

||||

```

|

||||

cargo rustc -- -C link-args="/ENTRY:_start /SUBSYSTEM:console"

|

||||

```

|

||||

|

||||

这里我们使用了 `CONSOLE` 子系统,如果使用 `WINDOWS` 子系统其实也可以。但是多次使用 `-C link-arg` 参数大可不必,我们可以如上面一样,将一个引号包裹起来的以空格分隔的列表传递给 `-C link-arg` 参数。

|

||||

|

||||

现在我们编译出的程序就可以在Windows平台成功运行了。

|

||||

|

||||

#### macOS

|

||||

|

||||

在macOS下,会触发以下链接错误(简化版):

|

||||

|

||||

```

|

||||

error: linking with `cc` failed: exit code: 1

|

||||

|

|

||||

= note: "cc" […]

|

||||

= note: ld: entry point (_main) undefined. for architecture x86_64

|

||||

clang: error: linker command failed with exit code 1 […]

|

||||

```

|

||||

|

||||

该错误告诉我们链接器找不到入口函数 `main` (由于某些原因,macOS平台下,所有函数都会具有 `_` 前缀)。要重设入口函数名,我们可以传入链接器参数 `-e` :

|

||||

|

||||

```

|

||||

cargo rustc -- -C link-args="-e __start"

|

||||

```

|

||||

|

||||

`-e` 参数可用于重设入口函数名。由于在macOS平台下,所有函数都具有 `_` 前缀,所以需要传入 `__start` ,而不是 `_start` 。

|

||||

|

||||

接下来,会出现一个新的链接错误:

|

||||

|

||||

```

|

||||

error: linking with `cc` failed: exit code: 1

|

||||

|

|

||||

= note: "cc" […]

|

||||

= note: ld: dynamic main executables must link with libSystem.dylib

|

||||

for architecture x86_64

|

||||

clang: error: linker command failed with exit code 1 […]

|

||||

```

|

||||

|

||||

macOS [并未官方支持静态链接][does not officially support statically linked binaries] ,并且在默认情况下程序会链接 `libSystem` 库。要复写这个设定并进行静态链接,我们可以传入链接器参数 `-static` :

|

||||

|

||||

[does not officially support statically linked binaries]: https://developer.apple.com/library/archive/qa/qa1118/_index.html

|

||||

|

||||

```

|

||||

cargo rustc -- -C link-args="-e __start -static"

|

||||

```

|

||||

|

||||

然而问题并没有解决,链接器再次抛出了一个错误:

|

||||

|

||||

```

|

||||

error: linking with `cc` failed: exit code: 1

|

||||

|

|

||||

= note: "cc" […]

|

||||

= note: ld: library not found for -lcrt0.o

|

||||

clang: error: linker command failed with exit code 1 […]

|

||||

```

|

||||

|

||||

该错误的原因是macOS平台下的程序会默认链接 `crt0` (即“C runtime zero”)。 这个错误实际上和Linux平台上的错误类似,可以添加链接器参数 `-nostartfiles` 解决:

|

||||

|

||||

```

|

||||

cargo rustc -- -C link-args="-e __start -static -nostartfiles"

|

||||

```

|

||||

|

||||

现在,我们的程序可以在macOS下编译成功了。

|

||||

|

||||

#### 统一编译命令

|

||||

|

||||

经过上面的章节,我们知道了在各个平台使用的编译命令是不同的,这十分不优雅。要解决这个问题,我们可以创建一个 `.cargo/config.toml` 文件,分别配置不同平台下所使用的参数:

|

||||

|

||||

```toml

|

||||

# in .cargo/config.toml

|

||||

|

||||

[target.'cfg(target_os = "linux")']

|

||||

rustflags = ["-C", "link-arg=-nostartfiles"]

|

||||

|

||||

[target.'cfg(target_os = "windows")']

|

||||

rustflags = ["-C", "link-args=/ENTRY:_start /SUBSYSTEM:console"]

|

||||

|

||||

[target.'cfg(target_os = "macos")']

|

||||

rustflags = ["-C", "link-args=-e __start -static -nostartfiles"]

|

||||

```

|

||||

|

||||

对应的 `rustflags` 配置项的值可以自动被填充到 `rustc` 的运行参数中。要寻找 `.cargo/config.toml` 更多的用法,可以看一下 [官方文档](https://doc.rust-lang.org/cargo/reference/config.html)。

|

||||

|

||||

现在只需要运行 `cargo build` 即可在全部三个平台编译我们的程序了。

|

||||

|

||||

#### 我们真的需要做这些?

|

||||

|

||||

尽管我们可以在Linux、Windows和macOS编译出可执行程序,但这可能并非是个好主意。

|

||||

因为我们的程序少了不少本该存在的东西,比如 `_start` 执行时的栈初始化。

|

||||

失去了C运行时,部分基于它的依赖项很可能无法正确执行,这会造成程序出现各式各样的异常,比如segmentation fault(段错误)。

|

||||

|

||||

如果你希望创建一个基于已存在的操作系统的最小类库,建议引用 `libc` ,阅读 [这里](https://doc.rust-lang.org/1.16.0/book/no-stdlib.html) 并恰当设定 `#[start]` 比较好。

|

||||

|

||||

</details>

|

||||

|

||||

## 小结

|

||||

|

||||

@@ -291,7 +459,18 @@ panic = "abort" # 禁用 panic 时栈展开

|

||||

cargo build --target thumbv7em-none-eabihf

|

||||

```

|

||||

|

||||

要注意的是,现在我们的代码只是一个 Rust 编写的独立式可执行程序的一个例子。运行这个二进制程序还需要很多准备,比如在 `_start` 函数之前需要一个已经预加载完毕的栈。所以为了真正运行这样的程序,我们还有很多事情需要做。

|

||||

另外,我们也可以选择以本地操作系统为目标进行编译:

|

||||

|

||||

```bash

|

||||

# Linux

|

||||

cargo rustc -- -C link-arg=-nostartfiles

|

||||

# Windows

|

||||

cargo rustc -- -C link-args="/ENTRY:_start /SUBSYSTEM:console"

|

||||

# macOS

|

||||

cargo rustc -- -C link-args="-e __start -static -nostartfiles"

|

||||

```

|

||||

|

||||

要注意的是,现在我们的代码只是一个 Rust 编写的独立式可执行程序的一个例子。运行这个二进制程序还需要很多准备,比如在 `_start` 函数之前需要一个已经预加载完毕的栈。所以为了真正运行这样的程序,**我们还有很多事情需要做**。

|

||||

|

||||

## 下篇预览

|

||||

|

||||

|

||||

@@ -0,0 +1,29 @@

|

||||

+++

|

||||

title = "Disable the Red Zone"

|

||||

weight = 1

|

||||

path = "zh-CN/red-zone"

|

||||

template = "edition-2/extra.html"

|

||||

+++

|

||||

|

||||

[红区][red zone] 是 [System V ABI] 提供的一种优化技术,它使得函数可以在不修改栈指针的前提下,临时使用其栈帧下方的128个字节。

|

||||

|

||||

[red zone]: https://eli.thegreenplace.net/2011/09/06/stack-frame-layout-on-x86-64#the-red-zone

|

||||

[System V ABI]: https://wiki.osdev.org/System_V_ABI

|

||||

|

||||

<!-- more -->

|

||||

|

||||

|

||||

|

||||

上图展示了一个包含了 `n` 个局部变量的栈帧。当方法开始执行时,栈指针会被调整到一个合适的位置,为返回值和局部变量留出足够的空间。

|

||||

|

||||

红区是位于调整后的栈指针下方,长度为128字节的区域,函数会使用这部分空间存储不会被跨函数调用的临时数据。所以在某些情况下(比如逻辑简短的叶函数),红区可以节省用于调整栈指针的两条机器指令。

|

||||

|

||||

然而红区优化有时也会引发无法处理的巨大问题(异常或者硬件中断),如果使用红区时发生了某种异常:

|

||||

|

||||

|

||||

|

||||

CPU和异常处理机制会把红色区域内的数据覆盖掉,但是被中断的函数依然在引用着这些数据。当函数从错误中恢复时,错误的数据就会引发更大的错误,这类错误往往需要[追踪数周][take weeks to debug]才能找到。

|

||||

|

||||

[take weeks to debug]: https://forum.osdev.org/viewtopic.php?t=21720

|

||||

|

||||

要在编写异常处理机制时避免这些隐蔽而难以追踪的bug,我们需要从一开始就禁用红区优化,具体到配置文件中的配置项,就是 `"disable-redzone": true`。

|

||||

@@ -0,0 +1,44 @@

|

||||

+++

|

||||

title = "Disable SIMD"

|

||||

weight = 2

|

||||

path = "zh-CN/disable-simd"

|

||||

template = "edition-2/extra.html"

|

||||

+++

|

||||

|

||||

[单指令多数据][Single Instruction Multiple Data (SIMD)] 指令允许在一个操作符(比如加法)内传入多组数据,以此加速程序执行速度。`x86_64` 架构支持多种SIMD标准:

|

||||

|

||||

[Single Instruction Multiple Data (SIMD)]: https://en.wikipedia.org/wiki/SIMD

|

||||

|

||||

<!-- more -->

|

||||

|

||||

- [MMX]: _多媒体扩展_ 指令集于1997年发布,定义了8个64位寄存器,分别被称为 `mm0` 到 `mm7`,不过,这些寄存器只是 [x87浮点执行单元][x87 floating point unit] 中寄存器的映射而已。

|

||||

- [SSE]: _流处理SIMD扩展_ 指令集于1999年发布,不同于MMX的复用浮点执行单元,该指令集加入了一个完整的新寄存器组,即被称为 `xmm0` 到 `xmm15` 的16个128位寄存器。

|

||||

- [AVX]: _先进矢量扩展_ 用于进一步扩展多媒体寄存器的数量,它定义了 `ymm0` 到 `ymm15` 共16个256位寄存器,但是这些寄存器继承于 `xmm`,例如 `xmm0` 寄存器是 `ymm0` 的低128位。

|

||||

|

||||

[MMX]: https://en.wikipedia.org/wiki/MMX_(instruction_set)

|

||||

[x87 floating point unit]: https://en.wikipedia.org/wiki/X87

|

||||

[SSE]: https://en.wikipedia.org/wiki/Streaming_SIMD_Extensions

|

||||

[AVX]: https://en.wikipedia.org/wiki/Advanced_Vector_Extensions

|

||||

|

||||

通过应用这些SIMD标准,计算机程序可以显著提高执行速度。优秀的编译器可以将常规循环自动优化为适用SIMD的代码,这种优化技术被称为 [自动矢量化][auto-vectorization]。

|

||||

|

||||

[auto-vectorization]: https://en.wikipedia.org/wiki/Automatic_vectorization

|

||||

|

||||

尽管如此,SIMD会让操作系统内核出现一些问题。具体来说,就是操作系统在处理硬件中断时,需要保存所有寄存器信息到内存中,在中断结束后再将其恢复以供使用。所以说,如果内核需要使用SIMD寄存器,那么每次处理中断需要备份非常多的数据(512-1600字节),这会显著地降低性能。要避免这部分性能损失,我们需要禁用 `sse` 和 `mmx` 这两个特性(`avx` 默认已禁用)。

|

||||

|

||||

我们可以在编译配置文件中的 `features` 配置项做出如下修改,加入以减号为前缀的 `mmx` 和 `sse` 即可:

|

||||

|

||||

```json

|

||||

"features": "-mmx,-sse"

|

||||

```

|

||||

|

||||

## 浮点数

|

||||

还有一件不幸的事,`x86_64` 架构在处理浮点数计算时,会用到 `sse` 寄存器,因此,禁用SSE的前提下使用浮点数计算LLVM都一定会报错。 更大的问题在于Rust核心库里就存在着为数不少的浮点数运算(如 `f32` 和 `f64` 的数个trait),所以试图避免使用浮点数是不可能的。

|

||||

|

||||

幸运的是,LLVM支持 `soft-float` 特性,这个特性可以使用整型运算在软件层面模拟浮点数运算,使得我们为内核关闭SSE成为了可能,只需要牺牲一点点性能。

|

||||

|

||||

要为内核打开 `soft-float` 特性,我们只需要在编译配置文件中的 `features` 配置项做出如下修改即可:

|

||||

|

||||

```json

|

||||

"features": "-mmx,-sse,+soft-float"

|

||||

```

|

||||

@@ -414,7 +414,7 @@ pub extern "C" fn _start() -> ! {

|

||||

# in Cargo.toml

|

||||

|

||||

[dependencies]

|

||||

bootloader = "0.9.8"

|

||||

bootloader = "0.9.23"

|

||||

```

|

||||

|

||||

افزودن بوتلودر به عنوان وابستگی برای ایجاد یک دیسک ایمیج قابل بوت کافی نیست. مشکل این است که ما باید هسته خود را با بوت لودر پیوند دهیم، اما کارگو از [اسکریپت های بعد از بیلد] پشتیبانی نمیکند.

|

||||

|

||||

@@ -14,7 +14,7 @@ translators = ["TheMimiCodes", "maximevaillancourt"]

|

||||

translation_contributors = ["alaincao"]

|

||||

+++

|

||||

|

||||

Dans cet article, nous créons un noyau Rust 64-bit minimal pour l'architecture x86. Nous continuons le travail fait dans l'article précédent ([freestanding Rust binary][binaire Rust autonome]) pour créer une image de disque amorçable qui affiche quelque chose à l'écran.

|

||||

Dans cet article, nous créons un noyau Rust 64-bit minimal pour l'architecture x86. Nous continuons le travail fait dans l'article précédent “[Un binaire Rust autonome][freestanding Rust binary]” pour créer une image de disque amorçable qui affiche quelque chose à l'écran.

|

||||

|

||||

[freestanding Rust binary]: @/edition-2/posts/01-freestanding-rust-binary/index.fr.md

|

||||

|

||||

@@ -30,7 +30,7 @@ Cet article est développé de manière ouverte sur [GitHub]. Si vous avez des p

|

||||

<!-- toc -->

|

||||

|

||||

## Le processus d'amorçage

|

||||

Quand vous allumez un ordinateur, il commence par exécuter le code du micrologiciel qui est enregistré dans la carte mère ([ROM]). Ce code performe un [power-on self-test][test d'auto-diagnostic de démarrage], détecte la mémoire volatile disponible, et pré-initialise le processeur et le matériel. Par la suite, il recherche un disque amorçable et commence le processus d'amorçage du noyau du système d'exploitation.

|

||||

Quand vous allumez un ordinateur, il commence par exécuter le code du micrologiciel qui est enregistré dans la carte mère ([ROM]). Ce code performe un [test d'auto-diagnostic de démarrage][power-on self-test], détecte la mémoire volatile disponible, et pré-initialise le processeur et le matériel. Par la suite, il recherche un disque amorçable et commence le processus d'amorçage du noyau du système d'exploitation.

|

||||

|

||||

[ROM]: https://fr.wikipedia.org/wiki/M%C3%A9moire_morte

|

||||

[power-on self-test]: https://fr.wikipedia.org/wiki/Power-on_self-test_(informatique)

|

||||

@@ -69,19 +69,19 @@ Pour éviter que chaque système d'exploitation implémente son propre bootloade

|

||||

[Multiboot]: https://wiki.osdev.org/Multiboot

|

||||

[GNU GRUB]: https://fr.wikipedia.org/wiki/GNU_GRUB

|

||||

|

||||

Pour créer un noyau compatible Multiboot, il suffit d'insérer une [Multiboot header][en-tête Multiboot] au début du fichier du noyau. Cela rend très simple l'amorçage d'un système d'exploitation depuis GRUB. Cependant, GRUB et le standard Multiboot présentent aussi quelques problèmes :

|

||||

Pour créer un noyau compatible Multiboot, il suffit d'insérer une [en-tête Multiboot][Multiboot header] au début du fichier du noyau. Cela rend très simple l'amorçage d'un système d'exploitation depuis GRUB. Cependant, GRUB et le standard Multiboot présentent aussi quelques problèmes :

|

||||

|

||||

[Multiboot header]: https://www.gnu.org/software/grub/manual/multiboot/multiboot.html#OS-image-format

|

||||

|

||||

- Ils supportent seulement le "protected mode" 32-bit. Cela signifie que vous devez encore effectuer la configuration du processeur pour passer au "long mode" 64-bit.

|

||||

- Ils sont conçus pour simplifier le bootloader plutôt que le noyau. Par exemple, le noyau doit être lié avec une [adjusted default page size][taille de page prédéfinie], étant donné que GRUB ne peut pas trouver les entêtes Multiboot autrement. Un autre exemple est que l'[boot information][information de boot], qui est fournies au noyau, contient plusieurs structures spécifiques à l'architecture au lieu de fournir des abstractions pures.

|

||||

- Ils sont conçus pour simplifier le bootloader plutôt que le noyau. Par exemple, le noyau doit être lié avec une [taille de page prédéfinie][adjusted default page size], étant donné que GRUB ne peut pas trouver les entêtes Multiboot autrement. Un autre exemple est que l'[information de boot][boot information], qui est fournies au noyau, contient plusieurs structures spécifiques à l'architecture au lieu de fournir des abstractions pures.

|

||||

- GRUB et le standard Multiboot sont peu documentés.

|

||||

- GRUB doit être installé sur un système hôte pour créer une image de disque amorçable depuis le fichier du noyau. Cela rend le développement sur Windows ou sur Mac plus difficile.

|

||||

|

||||

[adjusted default page size]: https://wiki.osdev.org/Multiboot#Multiboot_2

|

||||

[boot information]: https://www.gnu.org/software/grub/manual/multiboot/multiboot.html#Boot-information-format

|

||||

|

||||

En raison de ces désavantages, nous avons décidé de ne pas utiliser GRUB ou le standard Multiboot. Cependant, nous avons l'intention d'ajouter le support Multiboot à notre outil [bootimage], afin qu'il soit aussi possible de charger le noyau sur un système GRUB. Si vous êtes interessé par l'écriture d'un noyau Multiboot conforme, consultez la [first edition][première édition] de cette série d'articles.

|

||||

En raison de ces désavantages, nous avons décidé de ne pas utiliser GRUB ou le standard Multiboot. Cependant, nous avons l'intention d'ajouter le support Multiboot à notre outil [bootimage], afin qu'il soit aussi possible de charger le noyau sur un système GRUB. Si vous êtes interessé par l'écriture d'un noyau Multiboot conforme, consultez la [première édition][first edition] de cette série d'articles.

|

||||

|

||||

[first edition]: @/edition-1/_index.md

|

||||

|

||||

@@ -90,7 +90,7 @@ En raison de ces désavantages, nous avons décidé de ne pas utiliser GRUB ou l

|

||||

(Nous ne fournissons pas le support UEFI à l'heure actuelle, mais nous aimerions bien! Si vous voulez aider, dites-le nous dans cette [_issue_ GitHub](https://github.com/phil-opp/blog_os/issues/349).)

|

||||

|

||||

## Un noyau minimal

|

||||

Maintenant que nous savons à peu près comment un ordinateur démarre, il est temps de créer notre propre noyau minimal. Notre objectif est de créer une image de disque qui affiche “Hello World!” à l'écran lorsqu'il démarre. Nous ferons ceci en améliorant le [freestanding Rust binary][binaire Rust autonome] du dernier article.

|

||||

Maintenant que nous savons à peu près comment un ordinateur démarre, il est temps de créer notre propre noyau minimal. Notre objectif est de créer une image de disque qui affiche “Hello World!” à l'écran lorsqu'il démarre. Nous ferons ceci en améliorant le [binaire Rust autonome][freestanding Rust binary] du dernier article.

|

||||

|

||||

Comme vous vous en rappelez peut-être, nous avons créé un binaire autonome grâce à `cargo`, mais selon le système d'exploitation, nous avions besoin de différents points d'entrée et d'options de compilation. C'est dû au fait que `cargo` construit pour _système hôte_ par défaut, c'est-à-dire le système que vous utilisez. Ce n'est pas ce que nous voulons pour notre noyau, car un noyau qui s'exécute, par exemple, sur Windows n'a pas de sens. Nous voulons plutôt compiler pour un _système cible_ bien défini.

|

||||

|

||||

@@ -101,12 +101,12 @@ Pour gérer l'installation de Rust, je recommande fortement [rustup]. Il vous pe

|

||||

|

||||

[rustup]: https://www.rustup.rs/

|

||||

|

||||

La version nocturne du compilateur nous permet d'activer certaines fonctionnalités expérimentales en utilisant certains _drapeaux de fonctionalité_ dans le haut de notre fichier. Par exemple, nous pourrions activer [`asm!` macro][macro expérimentale `asm!`] pour écrire du code assembleur intégré en ajoutant `#![feature(asm)]` au haut de notre `main.rs`. Notez que ces fonctionnalités expérimentales sont tout à fait instables, ce qui veut dire que des versions futures de Rust pourraient les changer ou les retirer sans préavis. Pour cette raison, nous les utiliserons seulement lorsque strictement nécessaire.

|

||||

La version nocturne du compilateur nous permet d'activer certaines fonctionnalités expérimentales en utilisant certains _drapeaux de fonctionalité_ dans le haut de notre fichier. Par exemple, nous pourrions activer [macro expérimentale `asm!`][`asm!` macro] pour écrire du code assembleur intégré en ajoutant `#![feature(asm)]` au haut de notre `main.rs`. Notez que ces fonctionnalités expérimentales sont tout à fait instables, ce qui veut dire que des versions futures de Rust pourraient les changer ou les retirer sans préavis. Pour cette raison, nous les utiliserons seulement lorsque strictement nécessaire.

|

||||

|

||||

[`asm!` macro]: https://doc.rust-lang.org/stable/reference/inline-assembly.html

|

||||

|

||||

### Spécification de la cible

|

||||

Cargo supporte différent systèmes cibles avec le paramètre `--target`. La cible est définie par un soi-disant _[target triple][triplet de cible]_, qui décrit l'architecteur du processeur, le fabricant, le système d'exploitation, et l'interface binaire d'application ([ABI]). Par exemple, le triplet `x86_64-unknown-linux-gnu` décrit un système avec un processeur `x86_64`, sans fabricant défini, et un système d'exploitation Linux avec l'interface binaire d'application GNU. Rust supporte [plusieurs différents triplets de cible][platform-support], incluant `arm-linux-androideabi` pour Android ou [`wasm32-unknown-unknown` pour WebAssembly](https://www.hellorust.com/setup/wasm-target/).

|

||||

Cargo supporte différent systèmes cibles avec le paramètre `--target`. La cible est définie par un soi-disant _[triplet de cible][target triple]_, qui décrit l'architecteur du processeur, le fabricant, le système d'exploitation, et l'interface binaire d'application ([ABI]). Par exemple, le triplet `x86_64-unknown-linux-gnu` décrit un système avec un processeur `x86_64`, sans fabricant défini, et un système d'exploitation Linux avec l'interface binaire d'application GNU. Rust supporte [plusieurs différents triplets de cible][platform-support], incluant `arm-linux-androideabi` pour Android ou [`wasm32-unknown-unknown` pour WebAssembly](https://www.hellorust.com/setup/wasm-target/).

|

||||

|

||||

[target triple]: https://clang.llvm.org/docs/CrossCompilation.html#target-triple

|

||||

[ABI]: https://stackoverflow.com/a/2456882

|

||||

@@ -131,7 +131,7 @@ Pour notre système cible toutefois, nous avons besoin de paramètres de configu

|

||||

}

|

||||

```

|

||||

|

||||

La plupart des champs sont requis par LLVM pour générer le code pour cette plateforme. Par exemple, le champ [`data-layout`] définit la taille de divers types d'entiers, de nombres à virgule flottante, et de pointeurs. Puis, il y a des champs que Rust utilise pour de la compilation conditionelle, comme `target-pointer-width`. Le troisième type de champ définit comment la crate doit être construite. Par exemple, le champ `pre-link-args` spécifie les arguments fournis au [linker][lieur].

|

||||

La plupart des champs sont requis par LLVM pour générer le code pour cette plateforme. Par exemple, le champ [`data-layout`] définit la taille de divers types d'entiers, de nombres à virgule flottante, et de pointeurs. Puis, il y a des champs que Rust utilise pour de la compilation conditionelle, comme `target-pointer-width`. Le troisième type de champ définit comment la crate doit être construite. Par exemple, le champ `pre-link-args` spécifie les arguments fournis au [lieur][linker].

|

||||

|

||||

[`data-layout`]: https://llvm.org/docs/LangRef.html#data-layout

|

||||

[linker]: https://en.wikipedia.org/wiki/Linker_(computing)

|

||||

@@ -169,7 +169,7 @@ Plutôt que d'utiliser le lieur par défaut de la plateforme (qui pourrait ne pa

|

||||

"panic-strategy": "abort",

|

||||

```

|

||||

|

||||

Ce paramètre spécifie que la cible ne permet pas le [stack unwinding][déroulement de la pile] lorsque le noyau panique, alors le système devrait plutôt s'arrêter directement. Ceci mène au même résultat que l'option `panic = "abort"` dans notre Cargo.toml, alors nous pouvons la retirer de ce fichier. (Notez que, contrairement à l'option Cargo.toml, cette option de cible s'applique aussi quand nous recompilerons la bibliothèque `core` plus loin dans cet article. Ainsi, même si vous préférez garder l'option Cargo.toml, gardez cette option.)

|

||||

Ce paramètre spécifie que la cible ne permet pas le [déroulement de la pile][stack unwinding] lorsque le noyau panique, alors le système devrait plutôt s'arrêter directement. Ceci mène au même résultat que l'option `panic = "abort"` dans notre Cargo.toml, alors nous pouvons la retirer de ce fichier. (Notez que, contrairement à l'option Cargo.toml, cette option de cible s'applique aussi quand nous recompilerons la bibliothèque `core` plus loin dans cet article. Ainsi, même si vous préférez garder l'option Cargo.toml, gardez cette option.)

|

||||

|

||||

[stack unwinding]: https://www.bogotobogo.com/cplusplus/stackunwinding.php

|

||||

|

||||

@@ -177,7 +177,7 @@ Ce paramètre spécifie que la cible ne permet pas le [stack unwinding][déroule

|

||||

"disable-redzone": true,

|

||||

```

|

||||

|

||||

Nous écrivons un noyau, donc nous devrons éventuellement gérer les interruptions. Pour ce faire en toute sécurité, nous devons désactiver une optimisation de pointeur de pile nommée la _“zone rouge"_, puisqu'elle causerait une corruption de la pile autrement. Pour plus d'informations, lire notre article séparé à propos de la [disabling the red zone][désactivation de la zone rouge].

|

||||

Nous écrivons un noyau, donc nous devrons éventuellement gérer les interruptions. Pour ce faire en toute sécurité, nous devons désactiver une optimisation de pointeur de pile nommée la _“zone rouge"_, puisqu'elle causerait une corruption de la pile autrement. Pour plus d'informations, lire notre article séparé à propos de la [désactivation de la zone rouge][disabling the red zone].

|

||||

|

||||

[disabling the red zone]: @/edition-2/posts/02-minimal-rust-kernel/disable-red-zone/index.md

|

||||

|

||||

@@ -217,7 +217,7 @@ Notre fichier de spécification de cible ressemble maintenant à ceci :

|

||||

```

|

||||

|

||||

### Construction de notre noyau

|

||||

Compiler pour notre nouvelle cible utilisera les conventions Linux (je ne suis pas trop certain pourquoi; j'assume que c'est simplement le comportement par défaut de LLVM). Cela signifie que nos avons besoin d'un point d'entrée nommé `_start` comme décrit dans [previous post][l'article précédent]:

|

||||

Compiler pour notre nouvelle cible utilisera les conventions Linux (je ne suis pas trop certain pourquoi; j'assume que c'est simplement le comportement par défaut de LLVM). Cela signifie que nos avons besoin d'un point d'entrée nommé `_start` comme décrit dans [l'article précédent][previous post]:

|

||||

|

||||

[previous post]: @/edition-2/posts/01-freestanding-rust-binary/index.fr.md

|

||||

|

||||

@@ -253,7 +253,7 @@ Nous pouvons maintenant construire le noyau pour notre nouvelle cible en fournis

|

||||

error[E0463]: can't find crate for `core`

|

||||

```

|

||||

|

||||

Cela échoue! L'erreur nous dit que le compilateur ne trouve plus la [`core` library][bibliothèque `core`]. Cette bibliothèque contient les types de base Rust comme `Result`, `Option`, les itérateurs, et est implicitement liée à toutes les crates `no_std`.

|

||||

Cela échoue! L'erreur nous dit que le compilateur ne trouve plus la [bibliothèque `core`][`core` library]. Cette bibliothèque contient les types de base Rust comme `Result`, `Option`, les itérateurs, et est implicitement liée à toutes les crates `no_std`.

|

||||

|

||||

[`core` library]: https://doc.rust-lang.org/nightly/core/index.html

|

||||

|

||||

@@ -261,12 +261,12 @@ Le problème est que la bibliothèque `core` est distribuée avec le compilateur

|

||||

|

||||

#### L'option `build-std`

|

||||

|

||||

C'est ici que la [`build-std` feature][fonctionnalité `build-std`] de cargo entre en jeu. Elle permet de recompiler `core` et d'autres crates de la bibliothèque standard sur demande, plutôt que d'utiliser des versions précompilées incluses avec l'installation de Rust. Cette fonctionnalité est très récente et n'est pas encore complète, donc elle est définie comme instable et est seulement disponible avec les [nightly Rust compilers][versions nocturnes du compilateur Rust].

|

||||

C'est ici que la [fonctionnalité `build-std`][`build-std` feature] de cargo entre en jeu. Elle permet de recompiler `core` et d'autres crates de la bibliothèque standard sur demande, plutôt que d'utiliser des versions précompilées incluses avec l'installation de Rust. Cette fonctionnalité est très récente et n'est pas encore complète, donc elle est définie comme instable et est seulement disponible avec les [versions nocturnes du compilateur Rust][nightly Rust compilers].

|

||||

|

||||

[`build-std` feature]: https://doc.rust-lang.org/nightly/cargo/reference/unstable.html#build-std

|

||||

[nightly Rust compilers]: #installing-rust-nightly

|

||||

[nightly Rust compilers]: #installer-une-version-nocturne-de-rust

|

||||

|

||||

Pour utiliser cette fonctionnalité, nous devons créer un fichier de [cargo configuration][configuration cargo] dans `.cargo/config.toml` avec le contenu suivant:

|

||||

Pour utiliser cette fonctionnalité, nous devons créer un fichier de [configuration cargo][cargo configuration] dans `.cargo/config.toml` avec le contenu suivant:

|

||||

|

||||

```toml

|

||||

# dans .cargo/config.toml

|

||||

@@ -318,7 +318,7 @@ build-std = ["core", "compiler_builtins"]

|

||||

|

||||

(Le support pour la fonctionnalité `compiler-builtins-mem` a [été ajouté assez récemment](https://github.com/rust-lang/rust/pull/77284), donc vous aurez besoin de la version nocturne `2020-09-30` de Rust ou plus récent pour l'utiliser.)

|

||||

|

||||

Dans les coulisses, ce drapeau active la [`mem` feature][fonctionnalité `mem`] de la caisse `compiler_builtins`. Le résultat est que l'attribut `#[no_mangle]` est appliqué aux [`memcpy` etc. implementations][implémentations `memcpy` et autres] de la caise, ce qui les rend disponible au lieur.

|

||||

Dans les coulisses, ce drapeau active la [fonctionnalité `mem`][`mem` feature] de la crate `compiler_builtins`. Le résultat est que l'attribut `#[no_mangle]` est appliqué aux [implémentations `memcpy` et autres][`memcpy` etc. implementations] de la caise, ce qui les rend disponible au lieur.

|

||||

|

||||

[`mem` feature]: https://github.com/rust-lang/compiler-builtins/blob/eff506cd49b637f1ab5931625a33cef7e91fbbf6/Cargo.toml#L54-L55

|

||||

[`memcpy` etc. implementations]: https://github.com/rust-lang/compiler-builtins/blob/eff506cd49b637f1ab5931625a33cef7e91fbbf6/src/mem.rs#L12-L69

|

||||

@@ -327,7 +327,7 @@ Avec ce changement, notre noyau a des implémentations valides pour toutes les f

|

||||

|

||||

#### Définir une cible par défaut

|

||||

|

||||

Pour ne pas avoir à fournir le paramètre `--target` à chaque invocation de `cargo build`, nous pouvons définir la cible par défaut. Pour ce faire, nous ajoutons le code suivant à notre fichier de [cargo configuration][configuration Cargo] dans `.cargo/config.toml`:

|

||||

Pour ne pas avoir à fournir le paramètre `--target` à chaque invocation de `cargo build`, nous pouvons définir la cible par défaut. Pour ce faire, nous ajoutons le code suivant à notre fichier de [configuration Cargo][cargo configuration] dans `.cargo/config.toml`:

|

||||

|

||||

[cargo configuration]: https://doc.rust-lang.org/cargo/reference/config.html

|

||||

|

||||

@@ -338,7 +338,7 @@ Pour ne pas avoir à fournir le paramètre `--target` à chaque invocation de `c

|

||||

target = "x86_64-blog_os.json"

|

||||

```

|

||||

|

||||

Ceci indique à `cargo` d'utiliser notre cible `x86_64-blog_os.json` quand il n'y a pas d'argument de cible `--target` explicitement fourni. Ceci veut dire que nous pouvons maintenant construire notre noyau avec un simple `cargo build`. Pour plus d'informations sur les options de configuration cargo, jetez un coup d'oeil à la [official documentation][documentation officielle de cargo].

|

||||

Ceci indique à `cargo` d'utiliser notre cible `x86_64-blog_os.json` quand il n'y a pas d'argument de cible `--target` explicitement fourni. Ceci veut dire que nous pouvons maintenant construire notre noyau avec un simple `cargo build`. Pour plus d'informations sur les options de configuration cargo, jetez un coup d'oeil à la [documentation officielle de cargo][cargo configuration].

|

||||

|

||||

Nous pouvons maintenant construire notre noyau pour une cible "bare metal" avec un simple `cargo build`. Toutefois, notre point d'entrée `_start`, qui sera appelé par le bootloader, est encore vide. Il est temps de lui faire afficher quelque chose à l'écran.

|

||||

|

||||

@@ -371,7 +371,7 @@ pub extern "C" fn _start() -> ! {

|

||||

}

|

||||

```

|

||||

|

||||

D'abord, nous transformons l'entier `0xb8000` en un [raw pointer][pointeur brut]. Puis nous [iterate][parcourons] les octets de la [byte string][chaîne d'octets] [static][statique] `HELLO`. Nous utilisons la méthode [`enumerate`] pour aussi obtenir une variable `i`. Dans le corps de la boucle `for`, nous utilisons la méthode [`offset`] pour écrire la chaîne d'octets et l'octet de couleur correspondant(`0xb` est un cyan pâle).

|

||||

D'abord, nous transformons l'entier `0xb8000` en un [pointeur brut][raw pointer]. Puis nous [parcourons][iterate] les octets de la [chaîne d'octets][byte string] [statique][static] `HELLO`. Nous utilisons la méthode [`enumerate`] pour aussi obtenir une variable `i`. Dans le corps de la boucle `for`, nous utilisons la méthode [`offset`] pour écrire la chaîne d'octets et l'octet de couleur correspondant(`0xb` est un cyan pâle).

|

||||

|

||||

[iterate]: https://doc.rust-lang.org/stable/book/ch13-02-iterators.html

|

||||

[static]: https://doc.rust-lang.org/book/ch10-03-lifetime-syntax.html#the-static-lifetime

|

||||

@@ -380,14 +380,14 @@ D'abord, nous transformons l'entier `0xb8000` en un [raw pointer][pointeur brut]

|

||||

[raw pointer]: https://doc.rust-lang.org/stable/book/ch19-01-unsafe-rust.html#dereferencing-a-raw-pointer

|

||||

[`offset`]: https://doc.rust-lang.org/std/primitive.pointer.html#method.offset

|

||||

|

||||

Notez qu'il y a un bloc [`unsafe`] qui enveloppe les écritures mémoire. La raison en est que le compilateur Rust ne peut pas prouver que les pointeurs bruts que nous créons sont valides. Ils pourraient pointer n'importe où et mener à une corruption de données. En les mettant dans un bloc `unsafe`, nous disons fondamentalement au compilateur que nous sommes absolument certains que les opérations sont valides. Notez qu'un bloc `unsafe` ne désactive pas les contrôles de sécurité de Rust. Il permet seulement de faire [five additional things][cinq choses supplémentaires].

|

||||

Notez qu'il y a un bloc [`unsafe`] qui enveloppe les écritures mémoire. La raison en est que le compilateur Rust ne peut pas prouver que les pointeurs bruts que nous créons sont valides. Ils pourraient pointer n'importe où et mener à une corruption de données. En les mettant dans un bloc `unsafe`, nous disons fondamentalement au compilateur que nous sommes absolument certains que les opérations sont valides. Notez qu'un bloc `unsafe` ne désactive pas les contrôles de sécurité de Rust. Il permet seulement de faire [cinq choses supplémentaires][five additional things].

|

||||

|

||||

[`unsafe`]: https://doc.rust-lang.org/stable/book/ch19-01-unsafe-rust.html

|

||||

[five additional things]: https://doc.rust-lang.org/stable/book/ch19-01-unsafe-rust.html#unsafe-superpowers

|

||||

|

||||

Je veux souligner que **ce n'est pas comme cela que les choses se font en Rust!** Il est très facile de faire des erreurs en travaillant avec des pointeurs bruts à l'intérieur de blocs `unsafe`. Par exemple, nous pourrions facilement écrire au-delà de la fin du tampon si nous ne sommes pas prudents.

|

||||

|

||||

Alors nous voulons minimiser l'utilisation de `unsafe` autant que possible. Rust nous offre la possibilité de le faire en créant des abstractions de sécurité. Par exemple, nous pourrions créer un type tampon VGA qui encapsule les risques et qui s'assure qu'il est impossible de faire quoi que ce soit d'incorrect à l'extérieur de ce type. Ainsi, nous aurions besoin de très peu de code `unsafe` et nous serions certains que nous ne violons pas la [memory safety][sécurité de mémoire]. Nous allons créer une telle abstraction de tampon VGA buffer dans le prochain article.

|

||||

Alors nous voulons minimiser l'utilisation de `unsafe` autant que possible. Rust nous offre la possibilité de le faire en créant des abstractions de sécurité. Par exemple, nous pourrions créer un type tampon VGA qui encapsule les risques et qui s'assure qu'il est impossible de faire quoi que ce soit d'incorrect à l'extérieur de ce type. Ainsi, nous aurions besoin de très peu de code `unsafe` et nous serions certains que nous ne violons pas la [sécurité de mémoire][memory safety]. Nous allons créer une telle abstraction de tampon VGA buffer dans le prochain article.

|

||||

|

||||

[memory safety]: https://en.wikipedia.org/wiki/Memory_safety

|

||||

|

||||

@@ -397,9 +397,9 @@ Maintenant que nous avons un exécutable qui fait quelque chose de perceptible,

|

||||

|

||||

### Créer une image d'amorçage

|

||||

|

||||

Pour transformer notre noyau compilé en image de disque amorçable, nous devons le lier avec un bootloader. Comme nous l'avons appris dans la [section about booting][section à propos du lancement], le bootloader est responsable de l'initialisation du processeur et du chargement de notre noyau.

|

||||

Pour transformer notre noyau compilé en image de disque amorçable, nous devons le lier avec un bootloader. Comme nous l'avons appris dans la [section à propos du lancement][section about booting], le bootloader est responsable de l'initialisation du processeur et du chargement de notre noyau.

|

||||

|

||||

[section about booting]: #the-boot-process

|

||||

[section about booting]: #le-processus-d-amorcage

|

||||

|

||||

Plutôt que d'écrire notre propre bootloader, ce qui est un projet en soi, nous utilisons la crate [`bootloader`]. Cette crate propose un bootloader BIOS de base sans dépendance C. Seulement du code Rust et de l'assembleur intégré. Pour l'utiliser afin de lancer notre noyau, nous devons ajouter une dépendance à cette crate:

|

||||

|

||||

@@ -412,7 +412,7 @@ Plutôt que d'écrire notre propre bootloader, ce qui est un projet en soi, nous

|

||||

bootloader = "0.9.8"

|

||||

```

|

||||

|

||||

Ajouter le bootloader comme dépendance n'est pas suffisant pour réellement créer une image de disque amorçable. Le problème est que nous devons lier notre noyau avec le bootloader après la compilation, mais cargo ne supporte pas les [post-build scripts][scripts post-build].

|

||||

Ajouter le bootloader comme dépendance n'est pas suffisant pour réellement créer une image de disque amorçable. Le problème est que nous devons lier notre noyau avec le bootloader après la compilation, mais cargo ne supporte pas les [scripts post-build][post-build scripts].

|

||||

|

||||

[post-build scripts]: https://github.com/rust-lang/cargo/issues/545

|

||||

|

||||

@@ -474,7 +474,7 @@ Il est aussi possible d'écrire l'image disque sur une clé USB et de le lancer

|

||||

|

||||

Où `sdX` est le nom du périphérique de votre clé USB.

|

||||

|

||||

Après l'écriture de l'image sur votre clé USB, vous pouvez l'exécuter sur du véritable matériel en l'amorçant à partir de la clé USB. Vous devrez probablement utiliser un menu d'amorçage spécial ou changer l'ordre d'amorçage dans votre configuration BIOS pour amorcer à partir de la clé USB. Notez que cela ne fonctionne actuellement pas avec des ordinateurs UEFI, puisque la caisse `bootloader` ne supporte pas encore UEFI.

|

||||

Après l'écriture de l'image sur votre clé USB, vous pouvez l'exécuter sur du véritable matériel en l'amorçant à partir de la clé USB. Vous devrez probablement utiliser un menu d'amorçage spécial ou changer l'ordre d'amorçage dans votre configuration BIOS pour amorcer à partir de la clé USB. Notez que cela ne fonctionne actuellement pas avec des ordinateurs UEFI, puisque la crate `bootloader` ne supporte pas encore UEFI.

|

||||

|

||||

### Utilisation de `cargo run`

|

||||

|

||||

@@ -489,7 +489,7 @@ runner = "bootimage runner"

|

||||

|

||||

La table `target.'cfg(target_os = "none")'` s'applique à toutes les cibles dont le champ `"os"` dans le fichier de configuration est défini à `"none"`. Ceci inclut notre cible `x86_64-blog_os.json`. La clé `runner` key spécifie la commande qui doit être invoquée pour `cargo run`. La commande est exécutée après une build réussie avec le chemin de l'exécutable comme premier argument. Voir la [configuration cargo][cargo configuration] pour plus de détails.

|

||||

|

||||

La commande `bootimage runner` est spécifiquement conçue pour être utilisable comme un exécutable `runner`. Elle lie l'exécutable fourni avec le bootloader duquel dépend le projet et lance ensuite QEMU. Voir le [Readme of `bootimage`][README de `bootimage`] pour plus de détails et les options de configuration possibles.

|

||||

La commande `bootimage runner` est spécifiquement conçue pour être utilisable comme un exécutable `runner`. Elle lie l'exécutable fourni avec le bootloader duquel dépend le projet et lance ensuite QEMU. Voir le [README de `bootimage`][Readme of `bootimage`] pour plus de détails et les options de configuration possibles.

|

||||

|

||||

[Readme of `bootimage`]: https://github.com/rust-osdev/bootimage

|

||||

|

||||

|

||||

@@ -411,7 +411,7 @@ pub extern "C" fn _start() -> ! {

|

||||

# in Cargo.toml

|

||||

|

||||

[dependencies]

|

||||

bootloader = "0.9.8"

|

||||

bootloader = "0.9.23"

|

||||

```

|

||||

|

||||

bootloaderを依存として加えることだけでブータブルディスクイメージが実際に作れるわけではなく、私達のカーネルをコンパイル後にブートローダーにリンクする必要があります。問題は、cargoが[<ruby>ビルド後<rp> (</rp><rt>post-build</rt><rp>) </rp></ruby>にスクリプトを走らせる機能][post-build scripts]を持っていないことです。

|

||||

|

||||

@@ -418,7 +418,7 @@ pub extern "C" fn _start() -> ! {

|

||||

# Cargo.toml 에 들어갈 내용

|

||||

|

||||

[dependencies]

|

||||

bootloader = "0.9.8"

|

||||

bootloader = "0.9.23"

|

||||

```

|

||||

|

||||

부트로더를 의존 크레이트로 추가하는 것만으로는 부팅 가능한 디스크 이미지를 만들 수 없습니다. 커널 컴파일이 끝난 후 커널을 부트로더와 함께 링크할 수 있어야 하는데, cargo는 현재 [빌드 직후 스크립트 실행][post-build scripts] 기능을 지원하지 않습니다.

|

||||

|

||||

@@ -403,7 +403,7 @@ Instead of writing our own bootloader, which is a project on its own, we use the

|

||||

# in Cargo.toml

|

||||

|

||||

[dependencies]

|

||||

bootloader = "0.9.8"

|

||||

bootloader = "0.9.23"

|

||||

```

|

||||

|

||||

Adding the bootloader as a dependency is not enough to actually create a bootable disk image. The problem is that we need to link our kernel with the bootloader after compilation, but cargo has no support for [post-build scripts].

|

||||

|

||||

@@ -411,7 +411,7 @@ pub extern "C" fn _start() -> ! {

|

||||

# in Cargo.toml

|

||||

|

||||

[dependencies]

|

||||

bootloader = "0.9.8"

|

||||

bootloader = "0.9.23"

|

||||

```

|

||||

|

||||

Добавление загрузчика в качестве зависимости недостаточно для создания загрузочного образа диска. Проблема в том, что нам нужно связать наше ядро с загрузчиком после компиляции, но в cargo нет поддержки [скриптов после сборки][post-build scripts].

|

||||

|

||||

@@ -1,23 +1,25 @@

|

||||

+++

|

||||

title = "最小化内核"

|

||||

title = "最小内核"

|

||||

weight = 2

|

||||

path = "zh-CN/minimal-rust-kernel"

|

||||

date = 2018-02-10

|

||||

|

||||

[extra]

|

||||

# Please update this when updating the translation

|

||||

translation_based_on_commit = "bd6fbcb1c36705b2c474d7fcee387bfea1210851"

|

||||

translation_based_on_commit = "096c044b4f3697e91d8e30a2e817e567d0ef21a2"

|

||||

# GitHub usernames of the people that translated this post

|

||||

translators = ["luojia65", "Rustin-Liu"]

|

||||

translators = ["luojia65", "Rustin-Liu", "liuyuran"]

|

||||

# GitHub usernames of the people that contributed to this translation

|

||||

translation_contributors = ["JiangengDong"]

|

||||

+++

|

||||

|

||||

在这篇文章中,我们将基于 **x86架构**(the x86 architecture),使用 Rust 语言,编写一个最小化的 64 位内核。我们将从上一章中构建的独立式可执行程序开始,构建自己的内核;它将向显示器打印字符串,并能被打包为一个能够引导启动的**磁盘映像**(disk image)。

|

||||

在这篇文章中,我们将基于 **x86架构**(the x86 architecture),使用 Rust 语言,编写一个最小化的 64 位内核。我们将从上一章中构建的[独立式可执行程序][freestanding-rust-binary]开始,构建自己的内核;它将向显示器打印字符串,并能被打包为一个能够引导启动的**磁盘映像**(disk image)。

|

||||

|

||||

[freestanding Rust binary]: @/edition-2/posts/01-freestanding-rust-binary/index.md

|

||||

|

||||

<!-- more -->

|

||||

|

||||

This blog is openly developed on [GitHub]. If you have any problems or questions, please open an issue there. You can also leave comments [at the bottom]. The complete source code for this post can be found in the [`post-02`][post branch] branch.

|

||||

此博客在 [GitHub] 上公开开发. 如果您有任何问题或疑问,请在此处打开一个 issue。 您也可以在[底部][at the bottom]发表评论. 这篇文章的完整源代码可以在 [`post-02`] [post branch] 分支中找到。

|

||||

|

||||

[GitHub]: https://github.com/phil-opp/blog_os

|

||||

[at the bottom]: #comments

|

||||

@@ -32,7 +34,7 @@ This blog is openly developed on [GitHub]. If you have any problems or questions

|

||||

|

||||

x86 架构支持两种固件标准: **BIOS**([Basic Input/Output System](https://en.wikipedia.org/wiki/BIOS))和 **UEFI**([Unified Extensible Firmware Interface](https://en.wikipedia.org/wiki/Unified_Extensible_Firmware_Interface))。其中,BIOS 标准显得陈旧而过时,但实现简单,并为 1980 年代后的所有 x86 设备所支持;相反地,UEFI 更现代化,功能也更全面,但开发和构建更复杂(至少从我的角度看是如此)。

|

||||

|

||||

在这篇文章中,我们暂时只提供 BIOS 固件的引导启动方式。

|

||||

在这篇文章中,我们暂时只提供 BIOS 固件的引导启动方式,但是UEFI支持也已经在计划中了。如果你希望帮助我们推进它,请查阅这份 [Github issue](https://github.com/phil-opp/blog_os/issues/349)。

|

||||

|

||||

### BIOS 启动

|

||||

|

||||

@@ -57,11 +59,17 @@ x86 架构支持两种固件标准: **BIOS**([Basic Input/Output System](htt

|

||||

3. GRUB 和 Multiboot 标准并没有被详细地解释,阅读相关文档需要一定经验;

|

||||

4. 为了创建一个能够被引导的磁盘映像,我们在开发时必须安装 GRUB:这加大了基于 Windows 或 macOS 开发内核的难度。

|

||||

|

||||

出于这些考虑,我们决定不使用 GRUB 或者 Multiboot 标准。然而,Multiboot 支持功能也在 bootimage 工具的开发计划之中,所以从原理上讲,如果选用 bootimage 工具,在未来使用 GRUB 引导你的系统内核是可能的。

|

||||

出于这些考虑,我们决定不使用 GRUB 或者 Multiboot 标准。然而,Multiboot 支持功能也在 bootimage 工具的开发计划之中,所以从原理上讲,如果选用 bootimage 工具,在未来使用 GRUB 引导你的系统内核是可能的。 如果你对编写一个支持 Mutiboot 标准的内核有兴趣,可以查阅 [初版文档][first edition]。

|

||||

|

||||

## 最小化内核

|

||||

[first edition]: @/edition-1/_index.md

|

||||

|

||||

现在我们已经明白电脑是如何启动的,那也是时候编写我们自己的内核了。我们的小目标是,创建一个内核的磁盘映像,它能够在启动时,向屏幕输出一行“Hello World!”;我们的工作将基于上一章构建的独立式可执行程序。

|

||||

### UEFI

|

||||

|

||||

(截至此时,我们并未提供UEFI相关教程,但我们确实有此意向。如果你愿意提供一些帮助,请在 [Github issue](https://github.com/phil-opp/blog_os/issues/349) 告知我们,不胜感谢。)

|

||||

|

||||

## 最小内核

|

||||

|

||||

现在我们已经明白电脑是如何启动的,那也是时候编写我们自己的内核了。我们的小目标是,创建一个内核的磁盘映像,它能够在启动时,向屏幕输出一行“Hello World!”;我们的工作将基于上一章构建的[独立式可执行程序][freestanding Rust binary]。

|

||||

|

||||

如果读者还有印象的话,在上一章,我们使用 `cargo` 构建了一个独立的二进制程序;但这个程序依然基于特定的操作系统平台:因平台而异,我们需要定义不同名称的函数,且使用不同的编译指令。这是因为在默认情况下,`cargo` 会为特定的**宿主系统**(host system)构建源码,比如为你正在运行的系统构建源码。这并不是我们想要的,因为我们的内核不应该基于另一个操作系统——我们想要编写的,就是这个操作系统。确切地说,我们想要的是,编译为一个特定的**目标系统**(target system)。

|

||||

|

||||

@@ -135,7 +143,9 @@ Nightly 版本的编译器允许我们在源码的开头插入**特性标签**

|

||||

"disable-redzone": true,

|

||||

```

|

||||

|

||||

我们正在编写一个内核,所以我们应该同时处理中断。要安全地实现这一点,我们必须禁用一个与**红区**(redzone)有关的栈指针优化:因为此时,这个优化可能会导致栈被破坏。我们撰写了一篇专门的短文,来更详细地解释红区及与其相关的优化。

|

||||

我们正在编写一个内核,所以我们迟早要处理中断。要安全地实现这一点,我们必须禁用一个与**红区**(redzone)有关的栈指针优化:因为此时,这个优化可能会导致栈被破坏。如果需要更详细的资料,请查阅我们的一篇关于 [禁用红区][disabling the red zone] 的短文。

|

||||

|

||||

[disabling the red zone]: @/edition-2/posts/02-minimal-rust-kernel/disable-red-zone/index.zh-CN.md

|

||||

|

||||

```json

|

||||

"features": "-mmx,-sse,+soft-float",

|

||||

@@ -147,7 +157,7 @@ Nightly 版本的编译器允许我们在源码的开头插入**特性标签**

|

||||

|

||||

禁用 SIMD 产生的一个问题是,`x86_64` 架构的浮点数指针运算默认依赖于 SIMD 寄存器。我们的解决方法是,启用 `soft-float` 特征,它将使用基于整数的软件功能,模拟浮点数指针运算。

|

||||

|

||||

为了让读者的印象更清晰,我们撰写了一篇关于禁用 SIMD 的短文。

|

||||

为了让读者的印象更清晰,我们撰写了一篇关于 [禁用 SIMD][disabling SIMD](@/edition-2/posts/02-minimal-rust-kernel/disable-simd/index.zh-CN.md) 的短文。

|

||||

|

||||

现在,我们将各个配置项整合在一起。我们的目标配置清单应该长这样:

|

||||

|

||||

@@ -171,7 +181,9 @@ Nightly 版本的编译器允许我们在源码的开头插入**特性标签**

|

||||

|

||||

### 编译内核

|

||||

|

||||

要编译我们的内核,我们将使用 Linux 系统的编写风格(这可能是 LLVM 的默认风格)。这意味着,我们需要把前一篇文章中编写的入口点重命名为 `_start`:

|

||||

要编译我们的内核,我们将使用 Linux 系统的编写风格(这可能是 LLVM 的默认风格)。这意味着,我们需要把[前一篇文章][previous post]中编写的入口点重命名为 `_start`:

|

||||

|

||||

[previous post]: @/edition-2/posts/01-freestanding-rust-binary/index.md

|

||||

|

||||

```rust

|

||||

// src/main.rs

|

||||

@@ -203,61 +215,99 @@ pub extern "C" fn _start() -> ! {

|

||||

> cargo build --target x86_64-blog_os.json

|

||||

|

||||

error[E0463]: can't find crate for `core`

|

||||

(或者是下面的错误)

|

||||

error[E0463]: can't find crate for `compiler_builtins`

|

||||

```

|

||||

|

||||

哇哦,编译失败了!输出的错误告诉我们,Rust 编译器找不到 `core` 或者 `compiler_builtins` 包;而所有 `no_std` 上下文都隐式地链接到这两个包。[`core` 包](https://doc.rust-lang.org/nightly/core/index.html)包含基础的 Rust 类型,如` Result`、`Option` 和迭代器等;[`compiler_builtins` 包](https://github.com/rust-lang-nursery/compiler-builtins)提供 LLVM 需要的许多底层操作,比如 `memcpy`。

|

||||

毫不意外的编译失败了,错误信息告诉我们编译器没有找到 [`core`][`core` library] 这个crate,它包含了Rust语言中的部分基础类型,如 `Result`、`Option`、迭代器等等,并且它还会隐式链接到 `no_std` 特性里面。

|

||||

|

||||

通常状况下,`core` 库以**预编译库**(precompiled library)的形式与 Rust 编译器一同发布——这时,`core` 库只对支持的宿主系统有效,而我们自定义的目标系统无效。如果我们想为其它系统编译代码,我们需要为这些系统重新编译整个 `core` 库。

|

||||

[`core` library]: https://doc.rust-lang.org/nightly/core/index.html

|

||||

|

||||

### Cargo xbuild

|

||||

通常状况下,`core` crate以**预编译库**(precompiled library)的形式与 Rust 编译器一同发布——这时,`core` crate只对支持的宿主系统有效,而对我们自定义的目标系统无效。如果我们想为其它系统编译代码,我们需要为这些系统重新编译整个 `core` crate。

|

||||

|

||||

这就是为什么我们需要 [cargo xbuild 工具](https://github.com/rust-osdev/cargo-xbuild)。这个工具封装了 `cargo build`;但不同的是,它将自动交叉编译 `core` 库和一些**编译器内建库**(compiler built-in libraries)。我们可以用下面的命令安装它:

|

||||

#### `build-std` 选项

|

||||

|

||||

```bash

|

||||

cargo install cargo-xbuild

|

||||

此时就到了cargo中 [`build-std` 特性][`build-std` feature] 登场的时刻,该特性允许你按照自己的需要重编译 `core` 等标准crate,而不需要使用Rust安装程序内置的预编译版本。 但是该特性是全新的功能,到目前为止尚未完全完成,所以它被标记为 "unstable" 且仅被允许在 [nightly Rust 编译器][nightly Rust compilers] 环境下调用。

|

||||

|

||||

[`build-std` feature]: https://doc.rust-lang.org/nightly/cargo/reference/unstable.html#build-std

|

||||

[nightly Rust compilers]: #安装 Nightly Rust

|

||||

|

||||

要启用该特性,你需要创建一个 [cargo 配置][cargo configuration] 文件,即 `.cargo/config.toml`,并写入以下语句:

|

||||

|

||||

```toml

|

||||

# in .cargo/config.toml

|

||||

|

||||

[unstable]

|

||||

build-std = ["core", "compiler_builtins"]

|

||||

```

|

||||

|

||||

这个工具依赖于Rust的源代码;我们可以使用 `rustup component add rust-src` 来安装源代码。

|

||||

该配置会告知cargo需要重新编译 `core` 和 `compiler_builtins` 这两个crate,其中 `compiler_builtins` 是 `core` 的必要依赖。 另外重编译需要提供源码,我们可以使用 `rustup component add rust-src` 命令来下载它们。

|

||||

|

||||

现在我们可以使用 `xbuild` 代替 `build` 重新编译:

|

||||

<div class="note">

|

||||

|

||||

```bash

|

||||

> cargo xbuild --target x86_64-blog_os.json

|

||||

**Note:** 仅 `2020-07-15` 之后的Rust nightly版本支持 `unstable.build-std` 配置项。

|

||||

|

||||

</div>

|

||||

|

||||

在设定 `unstable.build-std` 配置项并安装 `rust-src` 组件之后,我们就可以开始编译了:

|

||||

|

||||

```

|

||||

> cargo build --target x86_64-blog_os.json

|

||||

Compiling core v0.0.0 (/…/rust/src/libcore)

|

||||

Compiling compiler_builtins v0.1.5

|

||||

Compiling rustc-std-workspace-core v1.0.0 (/…/rust/src/tools/rustc-std-workspace-core)

|

||||

Compiling alloc v0.0.0 (/tmp/xargo.PB7fj9KZJhAI)

|

||||

Finished release [optimized + debuginfo] target(s) in 45.18s

|

||||

Compiling blog_os v0.1.0 (file:///…/blog_os)

|

||||

Compiling rustc-std-workspace-core v1.99.0 (/…/rust/src/tools/rustc-std-workspace-core)

|

||||

Compiling compiler_builtins v0.1.32

|

||||

Compiling blog_os v0.1.0 (/…/blog_os)

|

||||

Finished dev [unoptimized + debuginfo] target(s) in 0.29 secs

|

||||

```

|

||||

|

||||

我们能看到,`cargo xbuild` 为我们自定义的目标交叉编译了 `core`、`compiler_builtin` 和 `alloc` 三个部件。这些部件使用了大量的**不稳定特性**(unstable features),所以只能在[nightly 版本的 Rust 编译器][installing rust nightly]中工作。这之后,`cargo xbuild` 成功地编译了我们的 `blog_os` 包。

|

||||

如你所见,在执行 `cargo build` 之后, `core`、`rustc-std-workspace-core` (`compiler_builtins` 的依赖)和 `compiler_builtins` crate被重新编译了。

|

||||

|

||||

[installing rust nightly]: #an-zhuang-nightly-rust

|

||||

#### 内存相关函数

|

||||

|

||||

现在我们可以为裸机编译内核了;但是,我们提供给引导程序的入口点 `_start` 函数还是空的。我们可以添加一些东西进去,不过我们可以先做一些优化工作。

|

||||

目前来说,Rust编译器假定所有内置函数(`built-in functions`)在所有系统内都是存在且可用的。事实上这个前提只对了一半,

|

||||

绝大多数内置函数都可以被 `compiler_builtins` 提供,而这个crate刚刚已经被我们重编译过了,然而部分内存相关函数是需要操作系统相关的标准C库提供的。

|

||||

比如,`memset`(该函数可以为一个内存块内的所有比特进行赋值)、`memcpy`(将一个内存块里的数据拷贝到另一个内存块)以及`memcmp`(比较两个内存块的数据)。

|

||||

好在我们的内核暂时还不需要用到这些函数,但是不要高兴的太早,当我们编写更丰富的功能(比如拷贝数据结构)时就会用到了。

|

||||

|

||||

### 设置默认目标

|

||||

现在我们当然无法提供操作系统相关的标准C库,所以我们需要使用其他办法提供这些东西。一个显而易见的途径就是自己实现 `memset` 这些函数,但不要忘记加入 `#[no_mangle]` 语句,以避免编译时被自动重命名。 当然,这样做很危险,底层函数中最细微的错误也会将程序导向不可预知的未来。比如,你可能在实现 `memcpy` 时使用了一个 `for` 循环,然而 `for` 循环本身又会调用 [`IntoIterator::into_iter`] 这个trait方法,这个方法又会再次调用 `memcpy`,此时一个无限递归就产生了,所以还是使用经过良好测试的既存实现更加可靠。

|

||||

|

||||

为了避免每次使用`cargo xbuild`时传递`--target`参数,我们可以覆写默认的编译目标。我们创建一个名为`.cargo/config`的[cargo配置文件](https://doc.rust-lang.org/cargo/reference/config.html),添加下面的内容:

|

||||

[`IntoIterator::into_iter`]: https://doc.rust-lang.org/stable/core/iter/trait.IntoIterator.html#tymethod.into_iter

|

||||

|

||||

幸运的是,`compiler_builtins` 事实上自带了所有相关函数的实现,只是在默认情况下,出于避免和标准C库发生冲突的考量被禁用掉了,此时我们需要将 [`build-std-features`] 配置项设置为 `["compiler-builtins-mem"]` 来启用这个特性。如同 `build-std` 配置项一样,该特性可以使用 `-Z` 参数启用,也可以在 `.cargo/config.toml` 中使用 `unstable` 配置集启用。现在我们的配置文件中的相关部分是这样子的:

|

||||

|

||||

[`build-std-features`]: https://doc.rust-lang.org/nightly/cargo/reference/unstable.html#build-std-features

|

||||

|

||||

```toml

|

||||

# in .cargo/config

|

||||

# in .cargo/config.toml

|

||||

|

||||

[unstable]

|

||||

build-std-features = ["compiler-builtins-mem"]

|

||||

build-std = ["core", "compiler_builtins"]

|

||||

```

|

||||

|

||||

(`compiler-builtins-mem` 特性是在 [这个PR](https://github.com/rust-lang/rust/pull/77284) 中被引入的,所以你的Rust nightly更新时间必须晚于 `2020-09-30`。)

|

||||

|

||||

该参数为 `compiler_builtins` 启用了 [`mem` 特性][`mem` feature],至于具体效果,就是已经在内部通过 `#[no_mangle]` 向链接器提供了 [`memcpy` 等函数的实现][`memcpy` etc. implementations]。

|

||||

|

||||

[`mem` feature]: https://github.com/rust-lang/compiler-builtins/blob/eff506cd49b637f1ab5931625a33cef7e91fbbf6/Cargo.toml#L54-L55

|

||||

[`memcpy` etc. implementations]: https://github.com/rust-lang/compiler-builtins/blob/eff506cd49b637f1ab5931625a33cef7e91fbbf6/src/mem.rs#L12-L69

|

||||

|

||||

经过这些修改,我们的内核已经完成了所有编译所必需的函数,那么让我们继续对代码进行完善。

|

||||

|

||||

#### 设置默认编译目标

|

||||

|

||||

每次调用 `cargo build` 命令都需要传入 `--target` 参数很麻烦吧?其实我们可以复写掉默认值,从而省略这个参数,只需要在 `.cargo/config.toml` 中加入以下 [cargo 配置][cargo configuration]:

|

||||

|

||||

[cargo configuration]: https://doc.rust-lang.org/cargo/reference/config.html

|

||||

|

||||

```toml

|

||||

# in .cargo/config.toml

|

||||

|

||||

[build]

|

||||

target = "x86_64-blog_os.json"

|

||||

```

|

||||

|

||||

这里的配置告诉 `cargo` 在没有显式声明目标的情况下,使用我们提供的 `x86_64-blog_os.json` 作为目标配置。这意味着保存后,我们可以直接使用:

|

||||

这个配置会告知 `cargo` 使用 `x86_64-blog_os.json` 这个文件作为默认的 `--target` 参数,此时只输入短短的一句 `cargo build` 就可以编译到指定平台了。如果你对其他配置项感兴趣,亦可以查阅 [官方文档][cargo configuration]。

|

||||

|

||||

```

|

||||

cargo xbuild

|

||||

```

|

||||

|

||||

来编译我们的内核。[官方提供的一份文档](https://doc.rust-lang.org/cargo/reference/config.html)中有对 cargo 配置文件更详细的说明。

|

||||

那么现在我们已经可以用 `cargo build` 完成程序编译了,然而被成功调用的 `_start` 函数的函数体依然是一个空空如也的循环,是时候往屏幕上输出一点什么了。

|

||||

|

||||

### 向屏幕打印字符

|

||||

|

||||

@@ -313,7 +363,7 @@ pub extern "C" fn _start() -> ! {

|

||||

# in Cargo.toml

|

||||

|

||||

[dependencies]

|

||||

bootloader = "0.9.3"

|

||||

bootloader = "0.9.23"

|

||||

```

|

||||

|

||||

只添加引导程序为依赖项,并不足以创建一个可引导的磁盘映像;我们还需要内核编译完成之后,将内核和引导程序组合在一起。然而,截至目前,原生的 cargo 并不支持在编译完成后添加其它步骤(详见[这个 issue](https://github.com/rust-lang/cargo/issues/545))。

|

||||

@@ -332,7 +382,7 @@ cargo install bootimage

|

||||

> cargo bootimage

|

||||

```

|

||||

|

||||

可以看到的是,`bootimage` 工具开始使用 `cargo xbuild` 编译你的内核,所以它将增量编译我们修改后的源码。在这之后,它会编译内核的引导程序,这可能将花费一定的时间;但和所有其它依赖包相似的是,在首次编译后,产生的二进制文件将被缓存下来——这将显著地加速后续的编译过程。最终,`bootimage` 将把内核和引导程序组合为一个可引导的磁盘映像。

|

||||

可以看到的是,`bootimage` 工具开始使用 `cargo build` 编译你的内核,所以它将增量编译我们修改后的源码。在这之后,它会编译内核的引导程序,这可能将花费一定的时间;但和所有其它依赖包相似的是,在首次编译后,产生的二进制文件将被缓存下来——这将显著地加速后续的编译过程。最终,`bootimage` 将把内核和引导程序组合为一个可引导的磁盘映像。

|

||||

|

||||

运行这行命令之后,我们应该能在 `target/x86_64-blog_os/debug` 目录内找到我们的映像文件 `bootimage-blog_os.bin`。我们可以在虚拟机内启动它,也可以刻录到 U 盘上以便在真机上启动。(需要注意的是,因为文件格式不同,这里的 bin 文件并不是一个光驱映像,所以将它刻录到光盘不会起作用。)

|

||||

|

||||

@@ -349,10 +399,13 @@ cargo install bootimage

|

||||

现在我们可以在虚拟机中启动内核了。为了在[ QEMU](https://www.qemu.org/) 中启动内核,我们使用下面的命令:

|

||||

|

||||

```bash

|

||||

> qemu-system-x86_64 -drive format=raw,file=bootimage-blog_os.bin

|

||||

> qemu-system-x86_64 -drive format=raw,file=target/x86_64-blog_os/debug/bootimage-blog_os.bin

|

||||

warning: TCG doesn't support requested feature: CPUID.01H:ECX.vmx [bit 5]

|

||||

```

|

||||

|

||||

|

||||

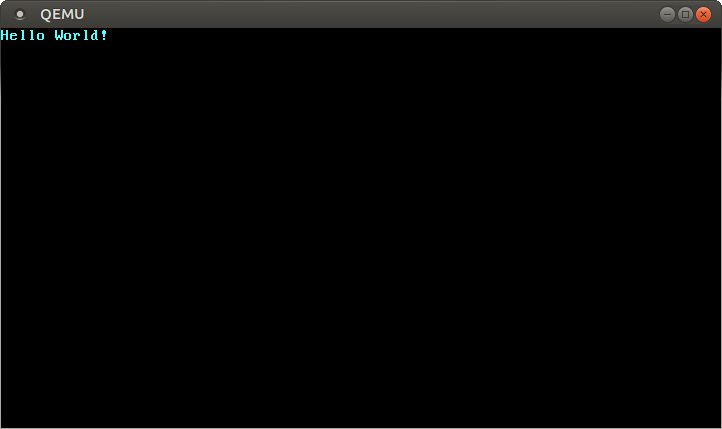

然后就会弹出一个独立窗口:

|

||||

|

||||

|

||||

|

||||

我们可以看到,屏幕窗口已经显示出 “Hello World!” 字符串。祝贺你!

|

||||

|

||||

@@ -383,7 +436,7 @@ runner = "bootimage runner"

|

||||

|

||||

命令 `bootimage runner` 由 `bootimage` 包提供,参数格式经过特殊设计,可以用于 `runner` 命令。它将给定的可执行文件与项目的引导程序依赖项链接,然后在 QEMU 中启动它。`bootimage` 包的 [README文档](https://github.com/rust-osdev/bootimage) 提供了更多细节和可以传入的配置参数。

|

||||

|

||||

现在我们可以使用 `cargo xrun` 来编译内核并在 QEMU 中启动了。和 `xbuild` 类似,`xrun` 子命令将在调用 cargo 命令前编译内核所需的包。这个子命令也由 `cargo-xbuild` 工具提供,所以你不需要安装额外的工具。

|

||||

现在我们可以使用 `cargo run` 来编译内核并在 QEMU 中启动了。

|

||||

|

||||

## 下篇预告

|

||||

|

||||

|

||||

@@ -12,7 +12,7 @@ translation_based_on_commit = "1c9b5edd6a5a667e282ca56d6103d3ff1fd7cfcb"

|

||||

translators = ["JOE1994", "Quqqu"]

|

||||

+++

|

||||

|

||||

[VGA 텍스트 모드][VGA text mode]를 통해 쉽게 화면에 텍스트를 출력할 수 있습니다. 이 포스트에서는 안전하지 않은 작업들을 분리된 모듈에 격리하여 쉽고 안전하게 VGA 텍스트 모드를 이용할 수 있는 인터페이스를 구현할 것입니다. 또한 Rust의 [서식 정렬 매크로 (formatting macro)][formatting macros]를 지원하도록 구현을 추가할 것입니다.

|

||||

[VGA 텍스트 모드][VGA text mode]를 통해 쉽게 화면에 텍스트를 출력할 수 있습니다. 이 글에서는 안전하지 않은 작업들을 분리된 모듈에 격리해 쉽고 안전하게 VGA 텍스트 모드를 이용할 수 있는 인터페이스를 구현합니다. 또한 Rust의 [서식 정렬 매크로 (formatting macro)][formatting macros]에 대한 지원을 추가할 것입니다.

|

||||

|

||||

[VGA text mode]: https://en.wikipedia.org/wiki/VGA-compatible_text_mode

|

||||

[formatting macros]: https://doc.rust-lang.org/std/fmt/#related-macros

|

||||

@@ -523,7 +523,7 @@ lazy_static! {

|

||||

}

|

||||

```

|

||||

|

||||

현재 `WRITER`는 immutable (읽기 가능, 쓰기 불가능) 하여 실질적인 쓸모가 없습니다. 모든 쓰기 함수들은 첫 인자로 `&mut self`를 받기 때문에 `WRITER`로 어떤 쓰기 작업도 할 수가 없습니다. 이에 대한 해결책으로 [mutable static]은 어떨까요? 이 선택지를 고른다면 모든 읽기 및 쓰기 작업이 데이터 경쟁 상태 (data race) 및 기타 위험에 노출되기에 안전을 보장할 수 없게 됩니다. Rust에서 `static mut`는 웬만하면 사용하지 않도록 권장되며, 심지어 [Rust 언어에서 완전히 `static mut`를 제거하자는 제안][remove static mut]이 나오기도 했습니다. 이것 이외에도 대안이 있을까요? [내부 가변성 (interior mutability)][interior mutability]을 제공하는 [RefCell] 혹은 [UnsafeCell] 을 통해 immutable한 정적 변수를 만드는 것은 어떨까요? 이 타입들은 중요한 이유로 [Sync] 트레이트를 구현하지 않기에 정적 변수를 선언할 때에는 사용할 수 없습니다.

|

||||

현재 `WRITER`는 immutable (읽기 가능, 쓰기 불가능) 하여 실질적인 쓸모가 없습니다. 모든 쓰기 함수들은 첫 인자로 `&mut self`를 받기 때문에 `WRITER`로 어떤 쓰기 작업도 할 수가 없습니다. 이에 대한 해결책으로 [mutable static]은 어떨까요? 이 선택지를 고른다면 모든 읽기 및 쓰기 작업이 데이터 레이스 (data race) 및 기타 위험에 노출되기에 안전을 보장할 수 없게 됩니다. Rust에서 `static mut`는 웬만하면 사용하지 않도록 권장되며, 심지어 [Rust 언어에서 완전히 `static mut`를 제거하자는 제안][remove static mut]이 나오기도 했습니다. 이것 이외에도 대안이 있을까요? [내부 가변성 (interior mutability)][interior mutability]을 제공하는 [RefCell] 혹은 [UnsafeCell] 을 통해 immutable한 정적 변수를 만드는 것은 어떨까요? 이 타입들은 중요한 이유로 [Sync] 트레이트를 구현하지 않기에 정적 변수를 선언할 때에는 사용할 수 없습니다.

|

||||

|

||||

[mutable static]: https://doc.rust-lang.org/book/ch19-01-unsafe-rust.html#accessing-or-modifying-a-mutable-static-variable

|

||||

[remove static mut]: https://internals.rust-lang.org/t/pre-rfc-remove-static-mut/1437

|

||||

|

||||

@@ -9,6 +9,8 @@ date = 2018-02-26

|

||||

translation_based_on_commit = "bd6fbcb1c36705b2c474d7fcee387bfea1210851"

|

||||

# GitHub usernames of the people that translated this post

|

||||

translators = ["luojia65", "Rustin-Liu"]

|

||||

# GitHub usernames of the people that contributed to this translation

|

||||

translation_contributors = ["liuyuran"]

|

||||

+++

|

||||

|

||||

**VGA 字符模式**([VGA text mode])是打印字符到屏幕的一种简单方式。在这篇文章中,为了包装这个模式为一个安全而简单的接口,我们将包装 unsafe 代码到独立的模块。我们还将实现对 Rust 语言**格式化宏**([formatting macros])的支持。

|

||||

@@ -18,7 +20,7 @@ translators = ["luojia65", "Rustin-Liu"]

|

||||

|

||||

<!-- more -->

|

||||

|

||||

This blog is openly developed on [GitHub]. If you have any problems or questions, please open an issue there. You can also leave comments [at the bottom]. The complete source code for this post can be found in the [`post-03`][post branch] branch.

|

||||

此博客在 [GitHub] 上公开开发. 如果您有任何问题或疑问,请在此处打开一个 issue。 您也可以在[底部][at the bottom]发表评论. 这篇文章的完整源代码可以在 [`post-03`] [post branch] 分支中找到。

|

||||

|

||||

[GitHub]: https://github.com/phil-opp/blog_os

|

||||

[at the bottom]: #comments

|

||||

@@ -31,27 +33,32 @@ This blog is openly developed on [GitHub]. If you have any problems or questions

|

||||

|

||||

为了在 VGA 字符模式中向屏幕打印字符,我们必须将它写入硬件提供的 **VGA 字符缓冲区**(VGA text buffer)。通常状况下,VGA 字符缓冲区是一个 25 行、80 列的二维数组,它的内容将被实时渲染到屏幕。这个数组的元素被称作**字符单元**(character cell),它使用下面的格式描述一个屏幕上的字符:

|

||||

|

||||

| Bit(s) | Value |

|

||||

|-----|----------------|

|

||||

| 0-7 | ASCII code point |

|

||||

| 8-11 | Foreground color |

|

||||

| 12-14 | Background color |

|

||||

| 15 | Blink |

|

||||

| Bit(s) | Value |

|

||||

| ------ | ---------------- |

|

||||

| 0-7 | ASCII code point |

|

||||

| 8-11 | Foreground color |

|

||||

| 12-14 | Background color |

|

||||

| 15 | Blink |

|

||||

|

||||

其中,**前景色**(foreground color)和**背景色**(background color)取值范围如下:

|

||||